Apple non poteva aspettare. Anche se il suo keynote di apertura del WWDC è previsto per l'inizio di giugno, il campo dell'intelligenza artificiale avanza ogni giorno, motivo per cui probabilmente non voleva perdere altro tempo. Sotto forma di comunicato stampa, ha illustrato cosa sarà in grado di fare la sua intelligenza artificiale in iOS 17 e ha aggiunto altre funzioni che ruotano attorno all'accessibilità. Ce n'è parecchio, le funzioni sono interessanti, ma c'è un punto interrogativo sull'usabilità di massa.

Potrebbe essere ti interessa

L'annuncio della notizia è stato supportato anche dalla Giornata mondiale dell'accessibilità, che cade giovedì, perché le funzionalità appena introdotte ruotano attorno all'accessibilità degli iPhone dalla A alla Z. L'accessibilità è un ampio blocco di funzionalità sull'iPhone che ha lo scopo di aiutare a controllarlo attraverso diverse forme di disabilità, anche se molte, ovviamente, tutti possono utilizzarle, il che vale anche per le novità che vedremo in iOS 17. Tuttavia, non tutte, come Assistive Access, sono basate al 100% sull'intelligenza artificiale.

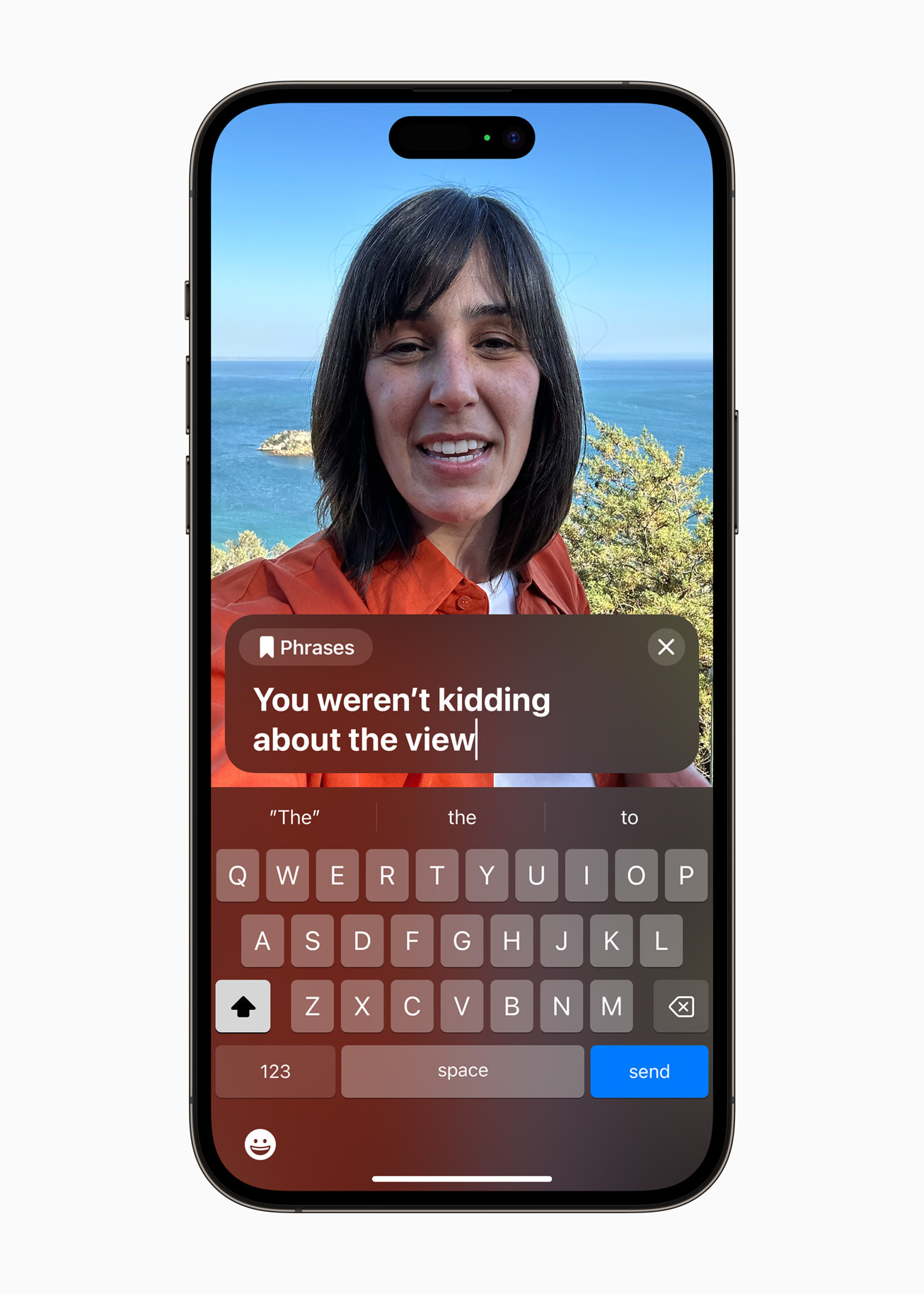

Discorso dal vivo

Ciò che scrivi sul display dell'iPhone verrà letto dall'altra parte. Dovrebbe funzionare localmente, anche se dovrebbe funzionare anche durante una chiamata telefonica. La funzione potrà lavorare in tempo reale, ma allo stesso tempo offrirà frasi preimpostate per rendere la comunicazione non solo più semplice, ma anche più veloce, quando non sarà necessario annotare le connessioni utilizzate di frequente. C’è una grande questione sulla disponibilità, cioè se funzionerà anche in lingua ceca. Lo speriamo, ma non ci crediamo troppo. Il che, del resto, vale anche per altre novità.

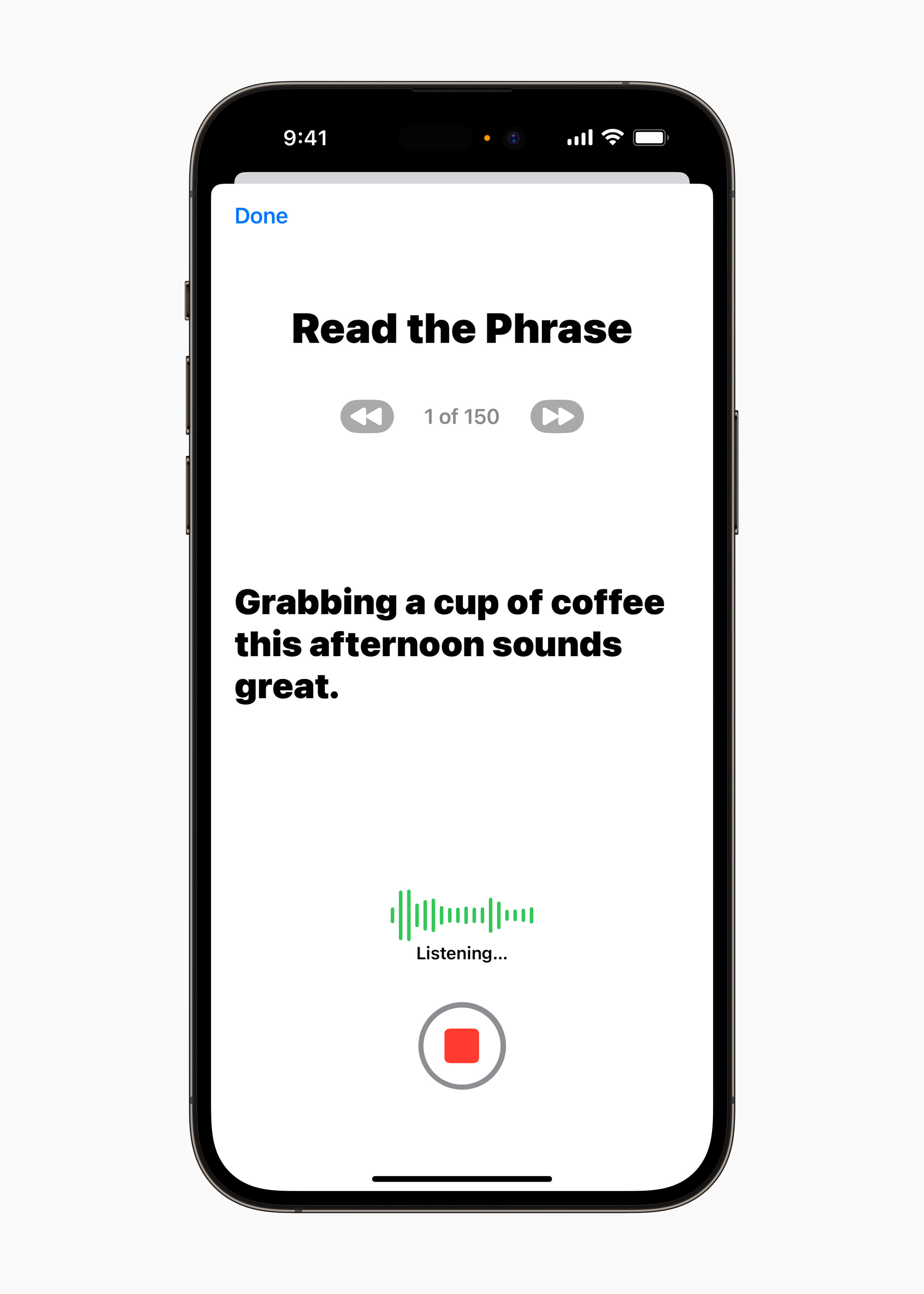

Voce personale

Dopo l'innovazione precedente c'è anche una funzione legata alla voce e al parlato, che, va detto, non ha ancora alcun parallelo. Con la funzione Voce Personale, gli iPhone potranno creare una copia esatta della tua voce, che potrai utilizzare nel caso del punto precedente. Il testo non sarà letto da una voce unanime, ma dalla vostra. Ad eccezione delle telefonate, questo può ovviamente essere utilizzato anche nei messaggi audio di iMessage, ecc. L'intera creazione della tua voce richiederà l'intelligenza artificiale e l'apprendimento automatico non più di 15 minuti, durante i quali leggerai il testo presentato e altro testo richiede. Quindi, se per qualche motivo perdi la voce, verrà salvata sul tuo iPhone e potrai ancora parlarci. Non dovrebbe rappresentare un rischio per la sicurezza, perché tutto avviene a livello locale.

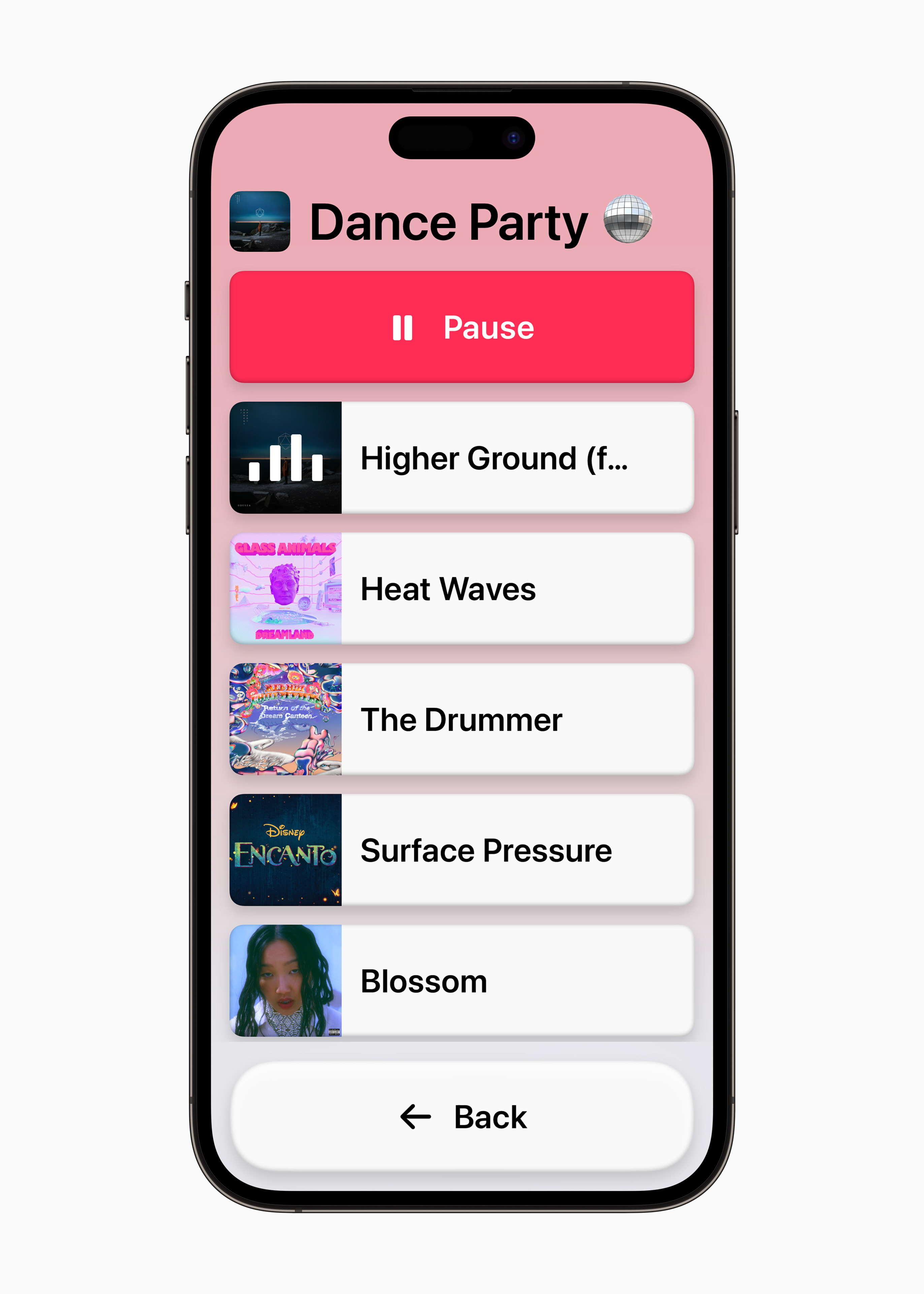

Approccio assistenziale

Nel mondo dei dispositivi Android, la modalità senior è una cosa abbastanza comune. Inoltre, è anche molto facile da usare, proprio come quella che adatta l'interfaccia ai più piccoli. Nel caso degli iPhone si è ipotizzato per molto tempo il primo, ma ora Apple lo ha finalmente rivelato. Attivandola, l'ambiente risulterà complessivamente semplificato, quando, ad esempio, verranno unificate applicazioni come Telefono e FaceTime, le icone saranno più grandi, e ci saranno anche delle personalizzazioni, grazie alle quali l'interfaccia verrà impostata esattamente secondo le esigenze dell'utente (puoi mettere un elenco invece di una griglia, ecc.).

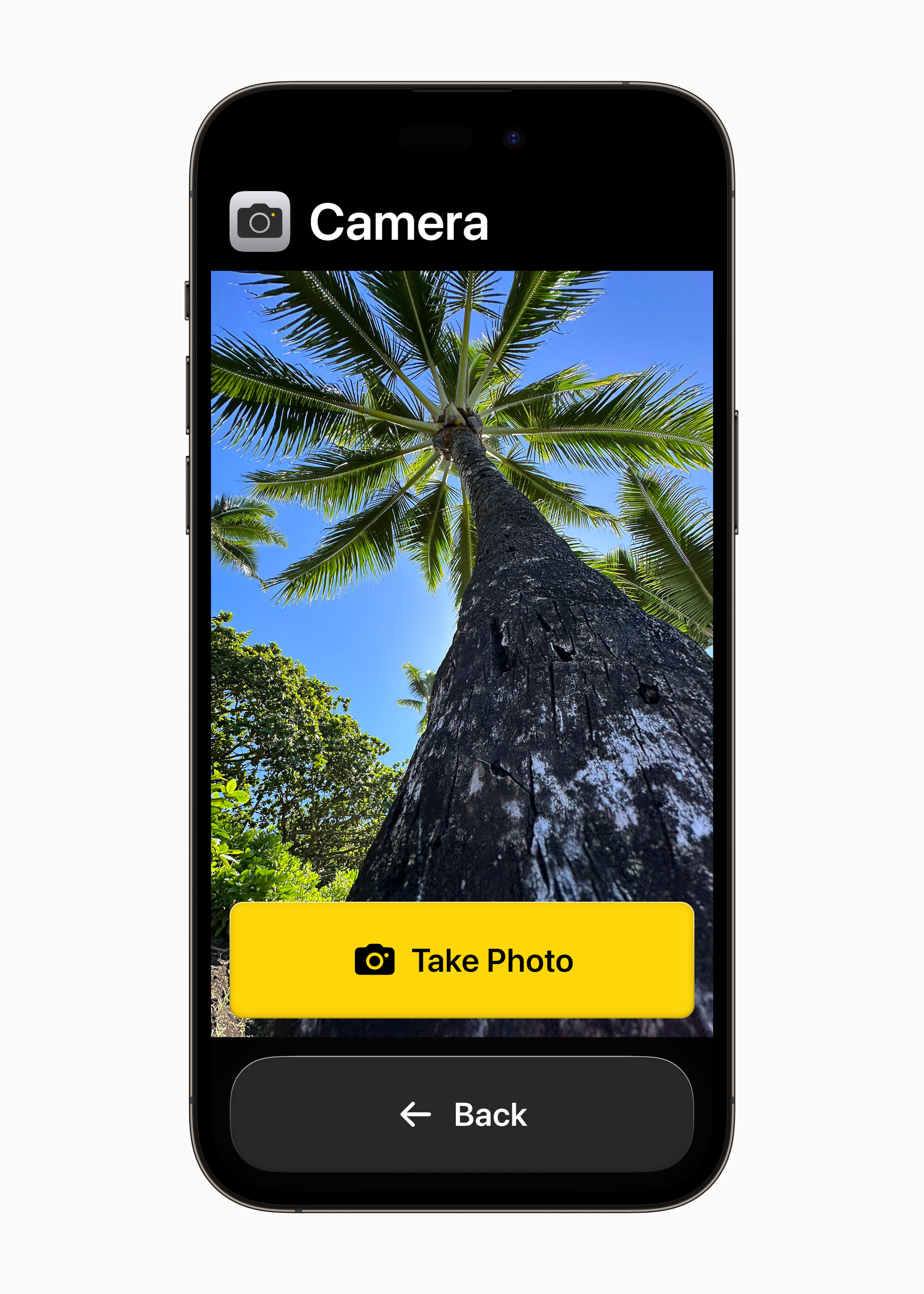

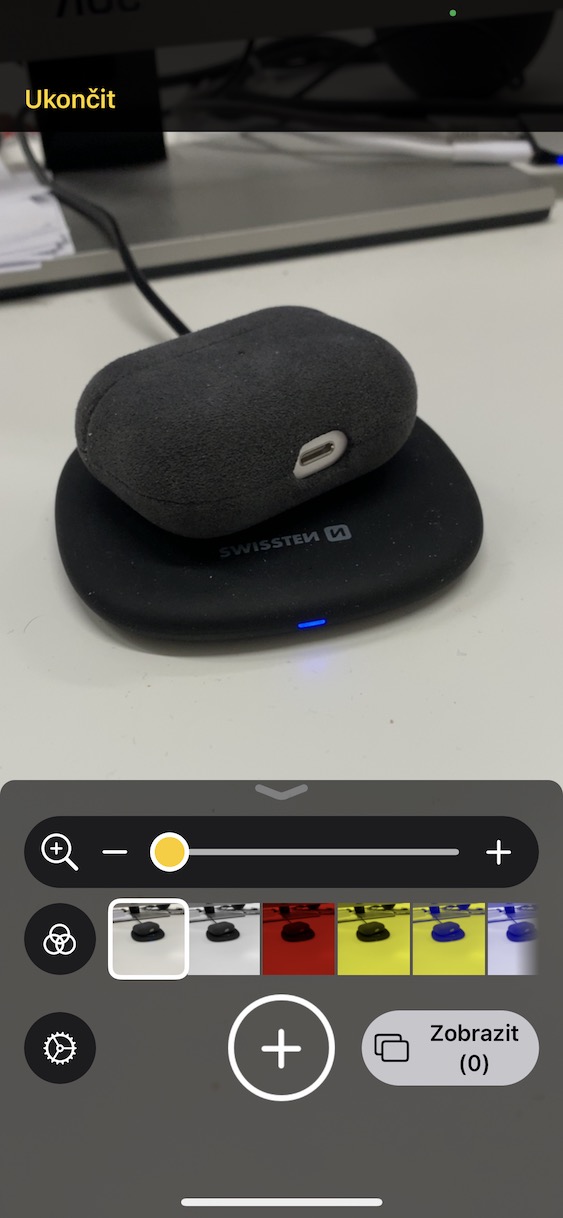

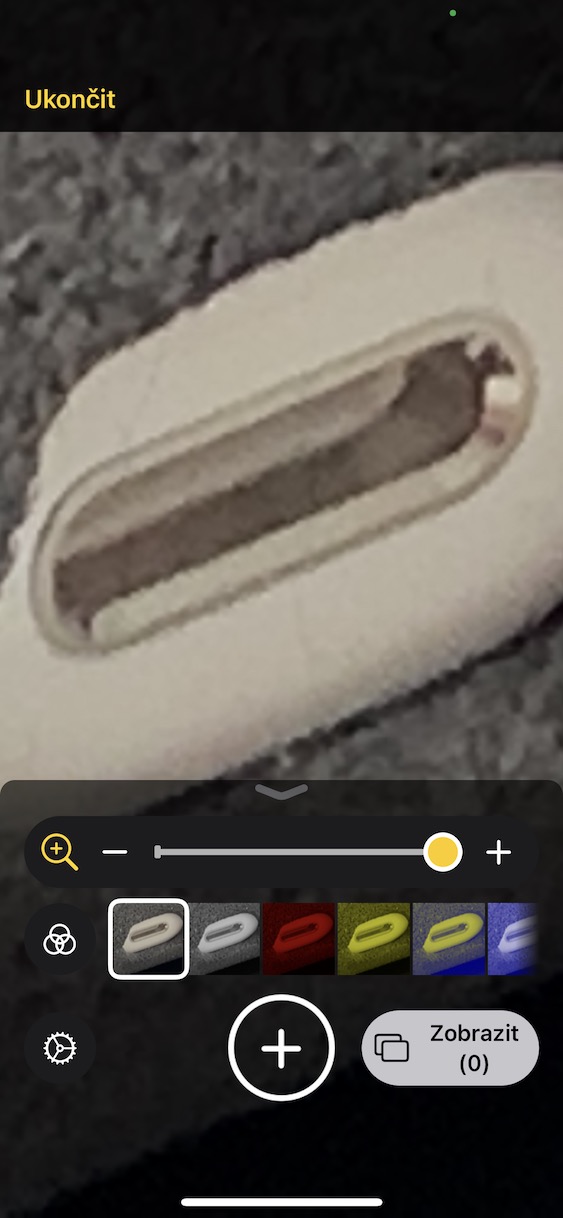

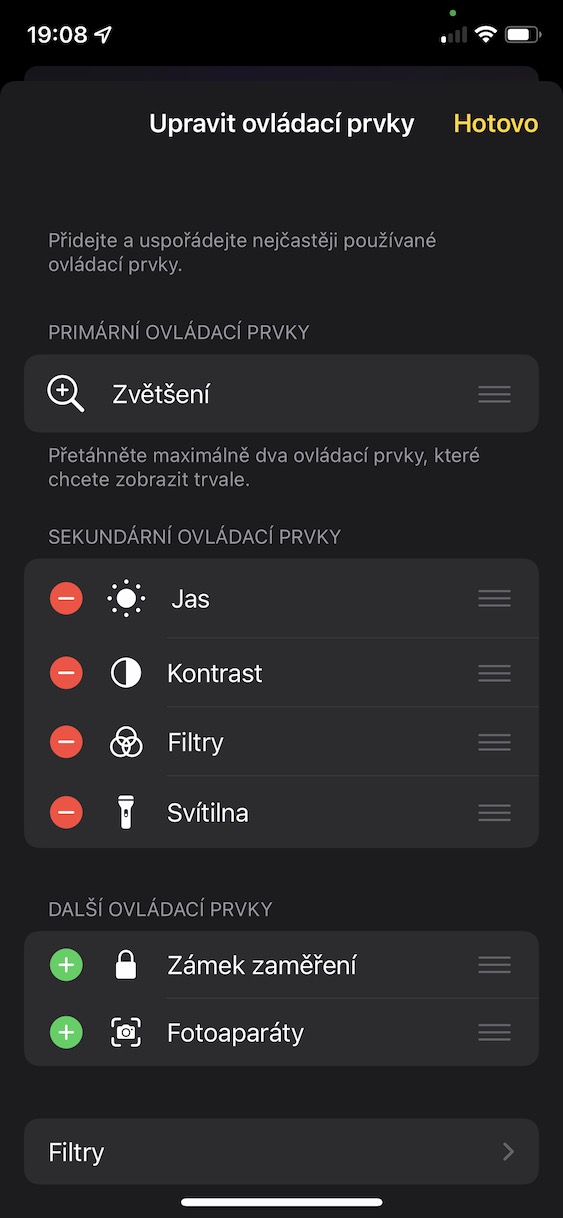

Modalità di rilevamento delle funzioni di ingrandimento

Se qualcuno soffre di problemi alla vista, Apple cercherà di semplificargli la vita utilizzando la funzione Magnifier, che utilizza l'apprendimento automatico e l'intelligenza artificiale per cercare di riconoscere ciò che l'utente del telefono sta puntando attraverso il mirino della fotocamera. La funzione dovrebbe quindi riconoscerlo correttamente e dirlo all'utente tramite voce. Dopotutto, nell'App Store ci sono molte applicazioni su questo argomento, sono piuttosto popolari e davvero funzionali, quindi è chiaro da dove Apple ha tratto ispirazione. Ma Apple si spinge ancora oltre nel caso del puntamento diretto, cioè sì, con il dito. Ciò è utile, ad esempio, con diversi pulsanti sugli elettrodomestici, quando l'utente saprà chiaramente quale dito ha e se deve premerlo. Tuttavia la lente d'ingrandimento dovrebbe essere in grado di riconoscere anche persone, animali e molte altre cose, cosa che può essere fatta anche da Google Lens.

Altre notizie Accessibilità

È stata pubblicata un'altra linea di funzioni, tra le quali vale la pena segnalarne due in particolare. La prima è la possibilità di mettere in pausa le immagini con elementi in movimento, tipicamente GIF, in Messaggi e Safari. Dopodiché, tocca alla velocità di conversazione di Siri, che potrai limitare da 0,8 fino a raddoppiare la velocità.

Potrebbe essere ti interessa

Adam Kos

Adam Kos